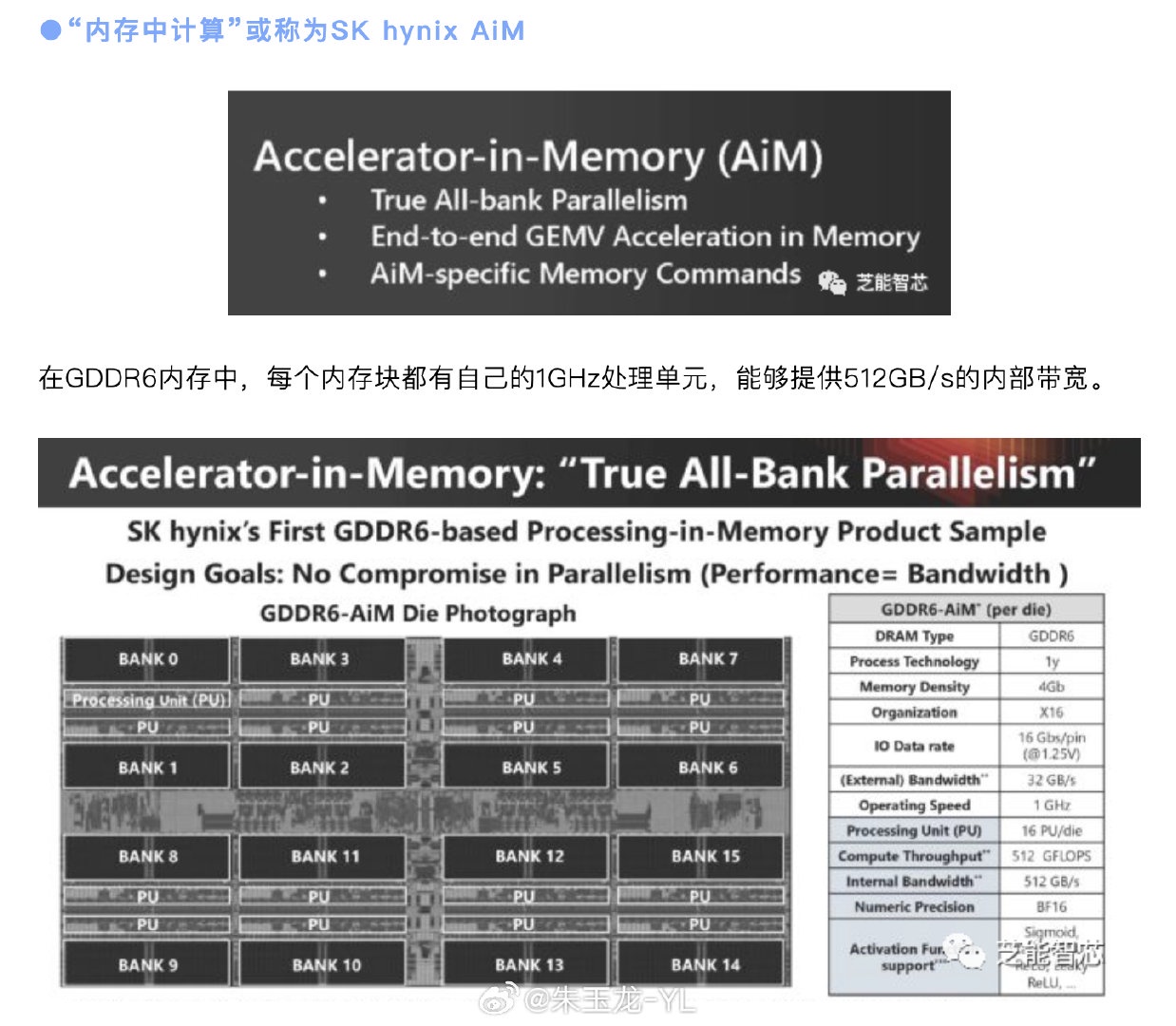

●“内存中计算” 或称为 SK hynix AiM

在 GDDR6 内存中,每个内存块都有自己的 1GHz 处理单元,能够提供 512GB/s 的内部带宽。

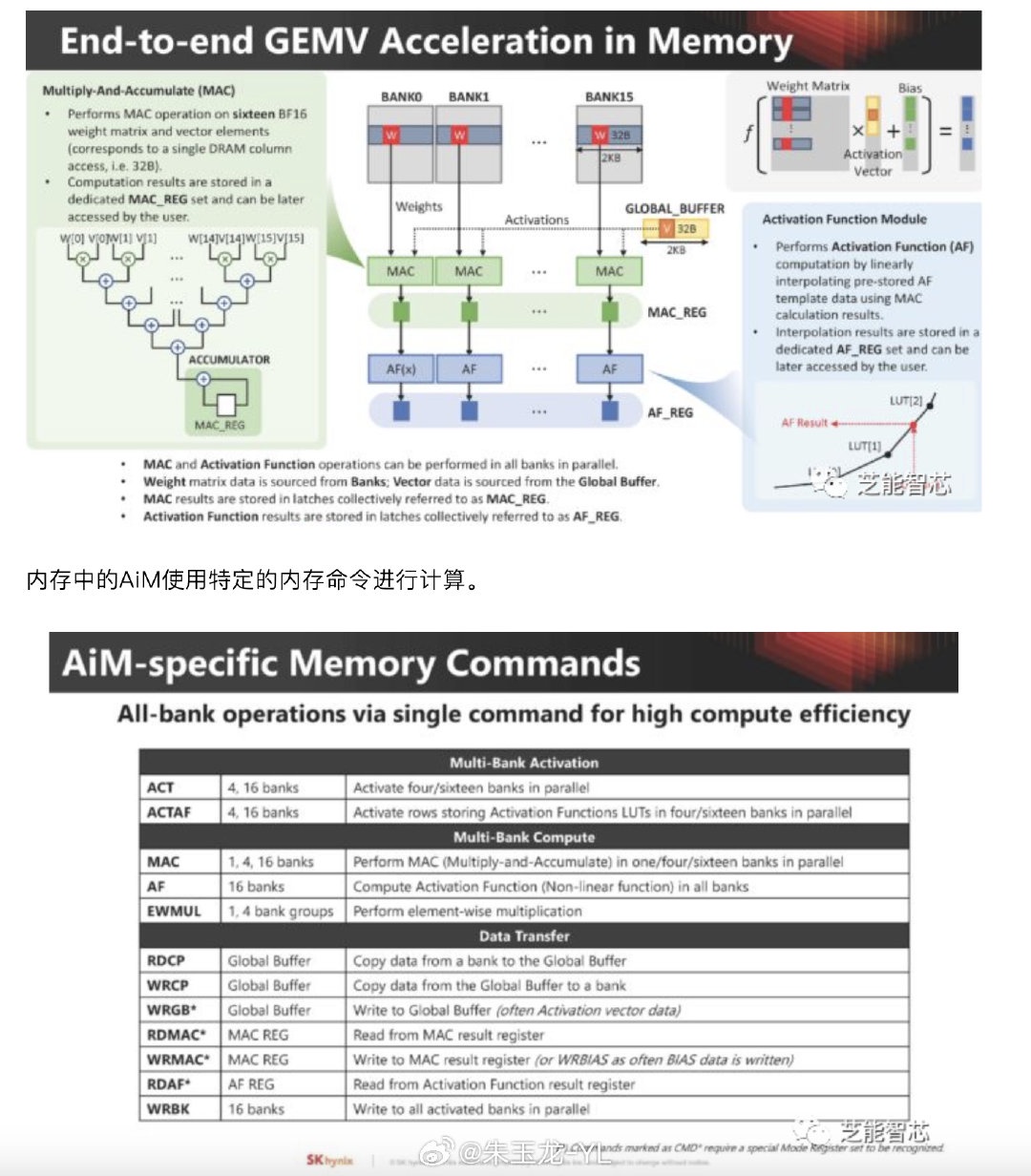

在内存中进行矩阵 - 向量乘法(GEMV)以进行人工智能计算,权重矩阵数据来自内存块,而向量数据来自全局缓冲区。

内存中的 AiM 使用特定的内存命令进行计算。

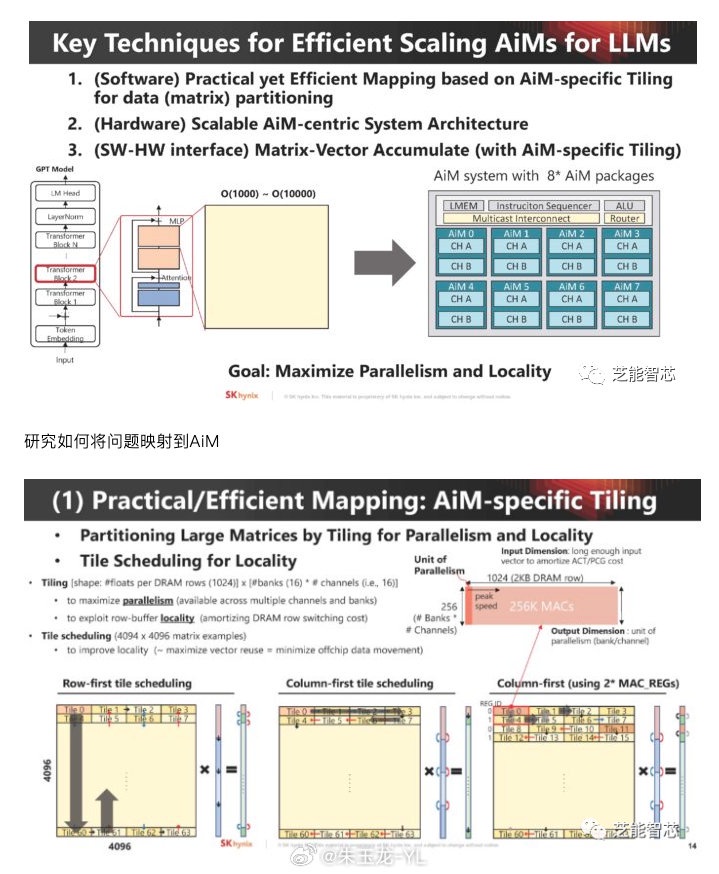

内存的扩展性,以及大型语言模型所需的内存中 AiM 计算资源。

使用这种 AiM 的情况下,主要挑战是需要在软件端进行映射,为 AiM 设计硬件架构,然后提供接口,这是采用这种技术的另一个主要障碍。

研究如何将问题映射到 AiM

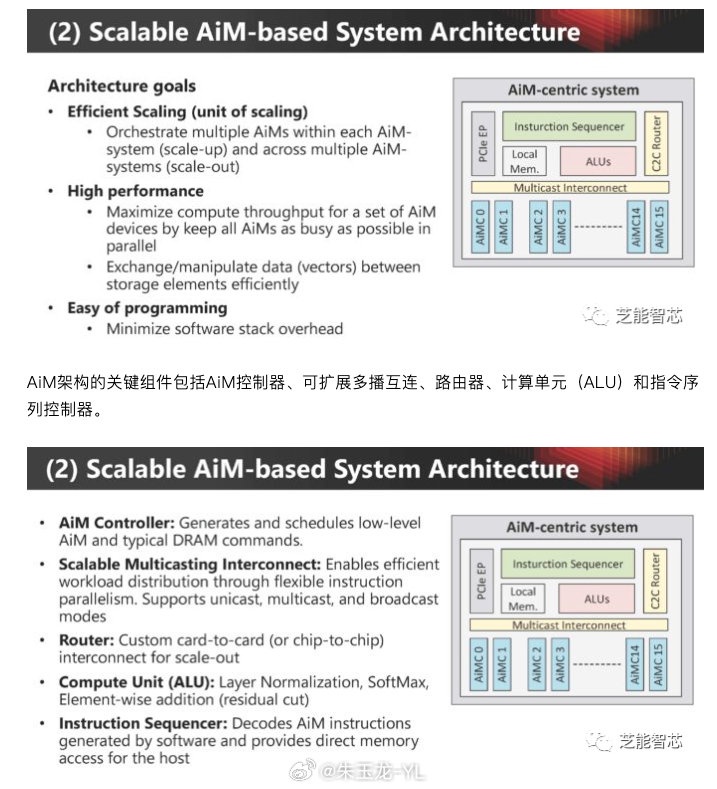

系统架构需要能够处理规模化和扩展性

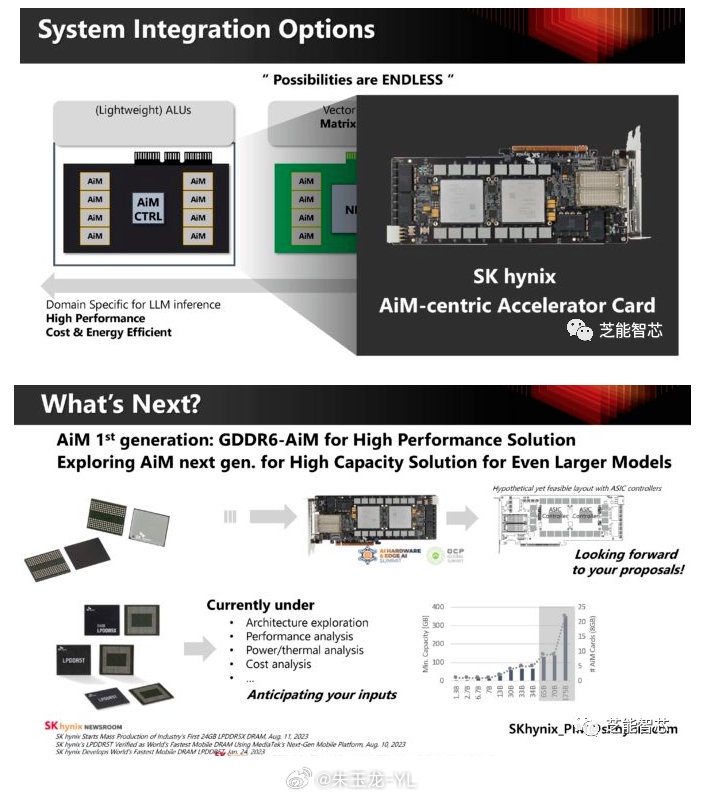

AiM 架构的关键组件包括 AiM 控制器、可扩展多播互连、路由器、计算单元(ALU)和指令序列控制器。

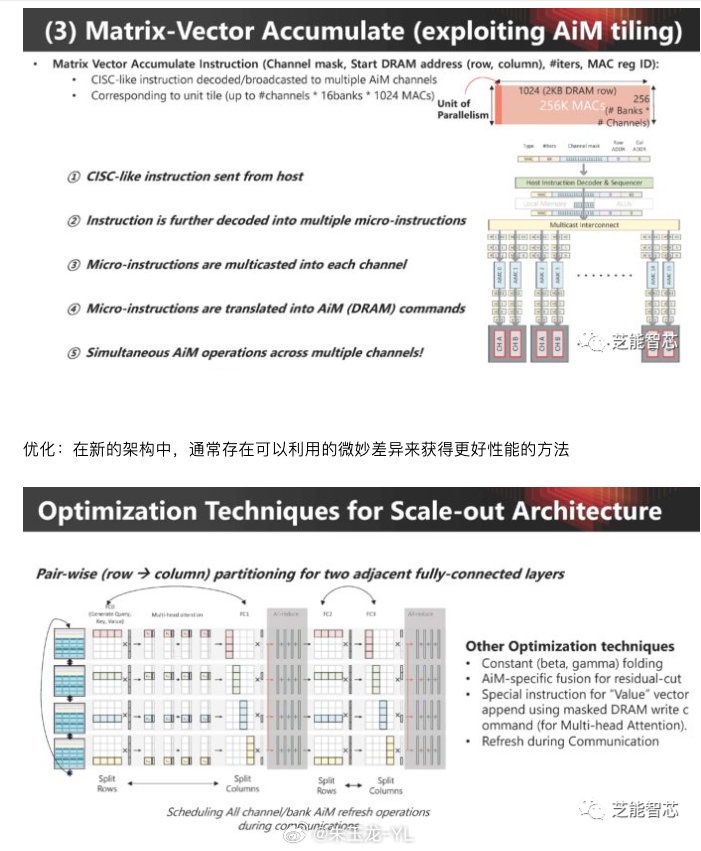

矩阵向量累积函数对人工智能工作负载至关重要,AiM 使用一种类似 CISC 的指令集来管理这些函数。

优化:在新的架构中,通常存在可以利用的微妙差异来获得更好性能的方法

SK hynix 不仅仅在抽象层面上讨论了 AiM 技术,展示了使用两个 FPGA 的 GDDR6 AiM 解决方案的概念验证。

AiM 软件堆栈

SK hynix 用来验证概念,仍然处于评估阶段,对这种解决方案与传统解决方案进行不同类型的分析。这是一个未来可能发展的方向。

本文版权归属原作者/机构所有。

当前内容仅代表作者观点,与本平台立场无关。内容仅供投资者参考,亦不构成任何投资建议。如对本平台提供的内容服务有任何疑问或建议,请联系我们。