人工智能需要怎样的服务器电源?

芝能科技出品

人工智能(AI)技术的突飞猛进引发了对计算能力的巨大需求,进而凸显了 AI 服务器电源的关键作用。

本文将从多个维度剖析 AI 服务器电源的发展现状,包括其重要性、技术特点、市场需求以及行业竞争。

01

AI 服务器电源的需求趋势

AI 技术的精进导致电力消耗剧增。据 Artificial Intelligence Index Report 2023 统计,各类先进 AI 模型如 DeepMind Gopher、Hugging Face BLOOM、OpenAI GPT-3、Meta OPT 的单次训练耗电量分别高达 1066MWh、433MWh、1287MWh 和 324MWh。

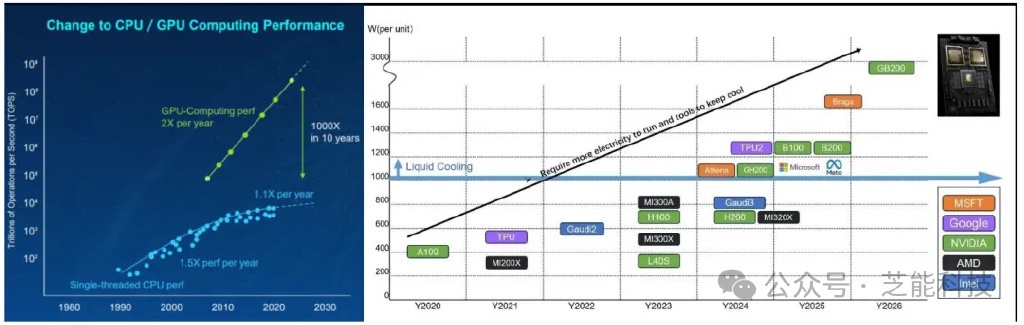

国际能源署(IEA)的数据指出,2023 年 NVIDIA 芯片的电力消耗已达 7.3TWh,预估至 2026 年,这一数字将飙升至 2023 年的十倍。在电力需求日益增长的情境下,高效能的服务器电源变得至关重要。相较于传统服务器电源 96% 的转换效率,AI 服务器电源需达到 97.5%-98% 的高标准,以降低能量损耗并支撑更高功率密度的 GPU。

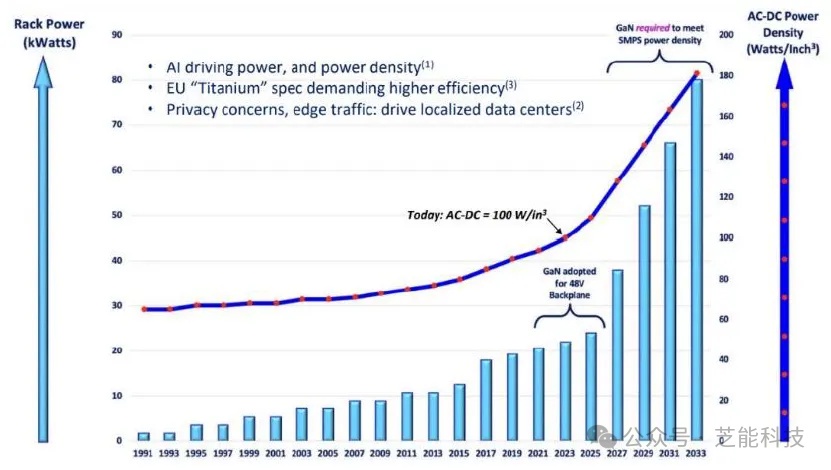

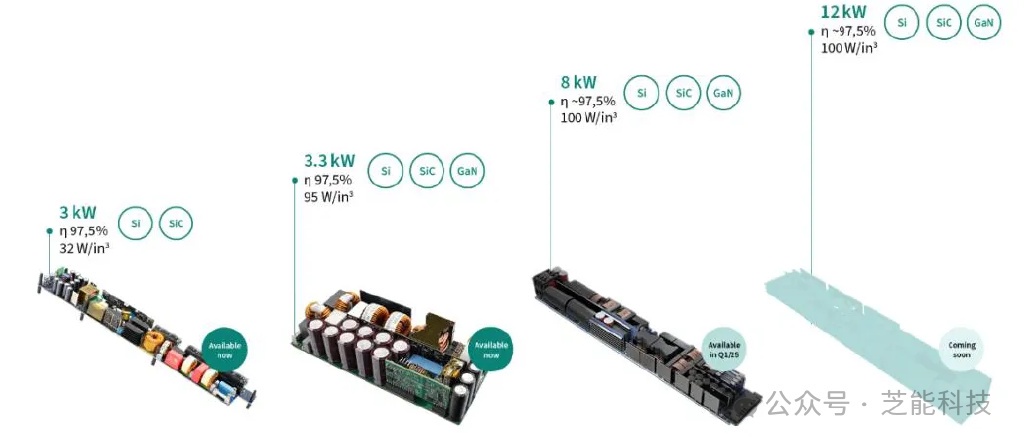

AI 模型与 GPU 技术的迭代促使 AI 服务器电源的功率密度不断提升。以 H100 服务器机架为例,10.2kW 的功率需要配备 19.8kW 的电源;而 NVL72 机架的 120kW 功率则要求 198kW 的电源模块。AI 服务器电源的功率密度可达 100W/立方英寸,远超普通服务器电源的 50W/立方英寸。

02

AI 服务器电源的技术架构与特性

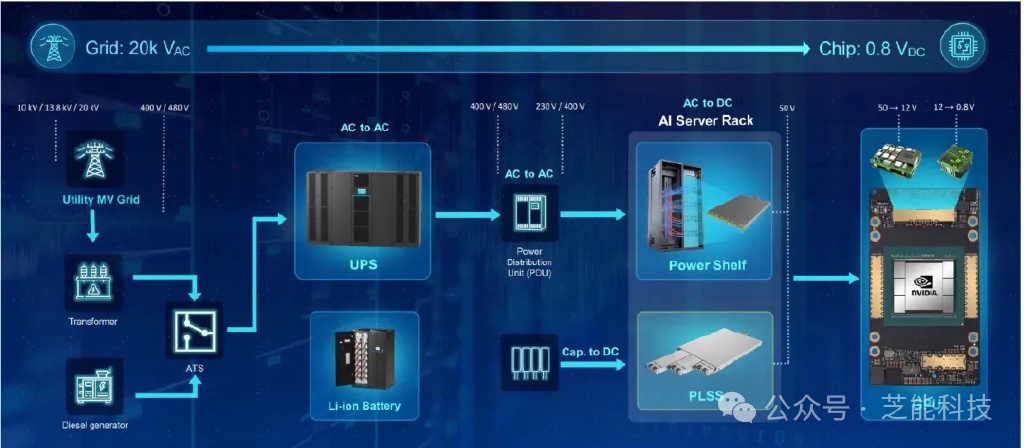

AI 服务器电源的架构由 UPS、AC/DC 和 DC/DC 三个层级构成,各司其职确保电力供应的连续性和稳定性。

● UPS:在电网中断时提供临时电力,保护数据免受损失。

● AC/DC:将电网的交流电转换为适合服务器使用的 50V 直流电。

● DC/DC:进一步将 50V 直流电降至芯片可接受的 0.8V。

AC/DC 电源模块包含电源模块(PSU)和电源管理控制器(PMC),例如,NVL72 服务器机架需配置 6 组电源架,总计 36 个模块,总功率 198kW。DC/DC 模块则要求紧密贴合负载,以减少供电网络的损耗。

AI 服务器电源的功率密度目标是 180W/立方英寸,这对散热技术提出了新的挑战。液冷技术因能有效提升温控性能,正逐步取代传统的风冷方案。

预计 2024/25 年,AI 服务器电源的 AC/DC 和 DC/DC 需求将分别达到 10.2GW/11.8GW 和 3GW/4GW。市场规模有望在 2025 年扩大至 156 亿至 272 亿元。当前市场由台系厂商引领,但国产品牌正在奋起直追,有望凭借持续的研发投入和技术积累,在未来占据一席之地。

小结

AI 服务器电源作为 AI 技术发展的基石,其技术创新和市场拓展将伴随 AI 领域的持续繁荣。面对未来,国产品牌需抓住机遇,迎接挑战,共同推动 AI 服务器电源行业的进步与创新。

本文版权归属原作者/机构所有。

当前内容仅代表作者观点,与本平台立场无关。内容仅供投资者参考,亦不构成任何投资建议。如对本平台提供的内容服务有任何疑问或建议,请联系我们。