AI 推理都落地了,却还是有的 99% 算力在空转?我们之前的文章里提到了一个核心症结: “内存墙”—— 数据传输速度远跟不上算力增长,GPU 等着数据 “投喂” 的时间,比实际计算时间多几百倍。比如生成一个 Token,计算仅需 10 微秒,加载数据却要 9 毫秒,大部分时间都在 “等材料”。

解决这个问题分两步走,短期见效快,中长期靠技术根治。

短期靠 “提速 + 缩距” 组合拳:一方面给 HBM(GPU 专用显存)升级,从 12-Hi 堆叠提到 16-Hi,带宽冲到 16-32TB/s,让数据传输 “提速加宽”;另一方面搭配 3D 堆叠 SRAM,把高频数据直接放在 GPU 旁边,传输延迟从 100ns 压到 2ns,两者分工 ——SRAM 负责 “快传”,HBM 负责 “多存”。英伟达收购 Groq 就是为了 SRAM 技术,2026 年下半年的 Rubin 芯片会融入这项技术,直接提升存力速度。

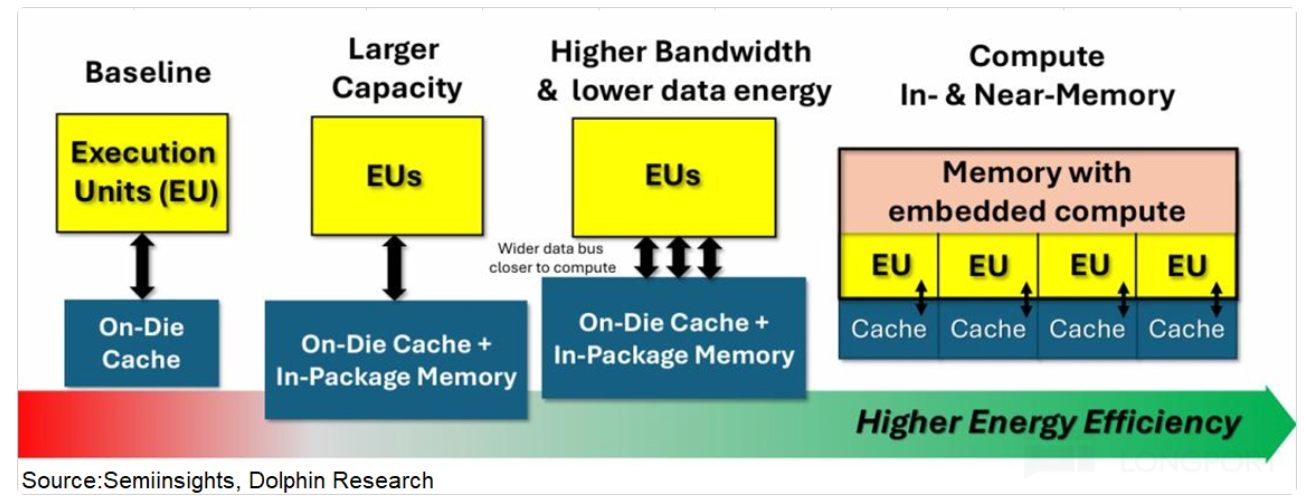

中长期则靠存算一体技术,把部分算力嵌进存储里,数据不用来回搬运,在存储中就能完成计算,从根源消除 “内存墙”。不过这项技术目前还没在数据中心落地,预计 2027 年后逐步推广。

随着 HBM4 2026 年量产、SRAM 技术商用,再加上后续存算一体落地,99% 算力闲置的问题才可能会逐步缓解,让 AI 推理真正 “满负荷干活”。

本文版权归属原作者/机构所有。

当前内容仅代表作者观点,与本平台立场无关。内容仅供投资者参考,亦不构成任何投资建议。如对本平台提供的内容服务有任何疑问或建议,请联系我们。